معرفی نسل هفتم Google TPU :

در سالهای اخیر با گسترش فناوری هوش مصنوعی (AI)، نیاز به توان محاسباتی بسیار بالا برای آموزش و اجرای مدلهای پیچیده افزایش یافته است. سنتاً GPUهای شرکت Nvidia بهدلیل معماری موازیساز قوی و توانایی بالا در محاسبات ماتریسی، هسته اصلی این فناوری بودند. اما با رشد سریع هوش مصنوعی، بهویژه در مقیاسهای فوقالعاده بزرگ، نیاز به سختافزارهای تخصصیتر و بهینهتر حس شد.

در پاسخ به این نیاز دنیای هوش مصنوعی، شرکت گوگل از سال ۲۰۱۵ میلادی ، خط تولید اختصاصی شتابدهندههای AI خود با نام TPU (Tensor Processing Unit) را توسعه داده است.

گوگل TPUها اغلب در زیرساختهای ابری این شرکت عرضه میشوند و از طریق Google Cloud قابل دسترسی هستند. این موضوع به کاربران این امکان را میدهد که بدون سرمایهگذاری عظیم در خرید سختافزار، از توان محاسباتی بالا استفاده کنند.

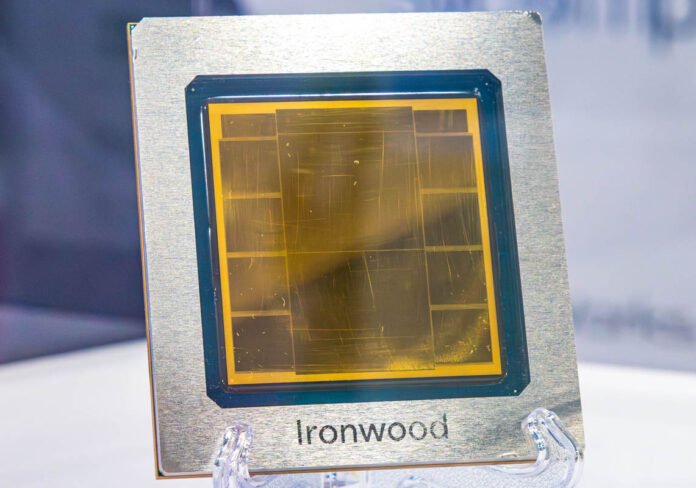

چیپ Ironwood، نسل هفتم TPU گوگل :

معرفی و معماری

در آوریل ۲۰۲۵ گوگل نسل جدید TPU خود با نام Ironwood (TPUv7) را معرفی کرد. این چیپ که بهعنوان قویترین TPU تاکنون شناخته میشود، برای دورهای به نام « عصر استنتاج (Inference)» طراحی شده است، یعنی زمانی که مدلهای هوش مصنوعی پس از آموزش برای پاسخگویی به ورودیهای واقعی بهکار میروند.

نسل Ironwood با پیشرفتهای اساسی در سه بخش کلیدی طراحی شده:

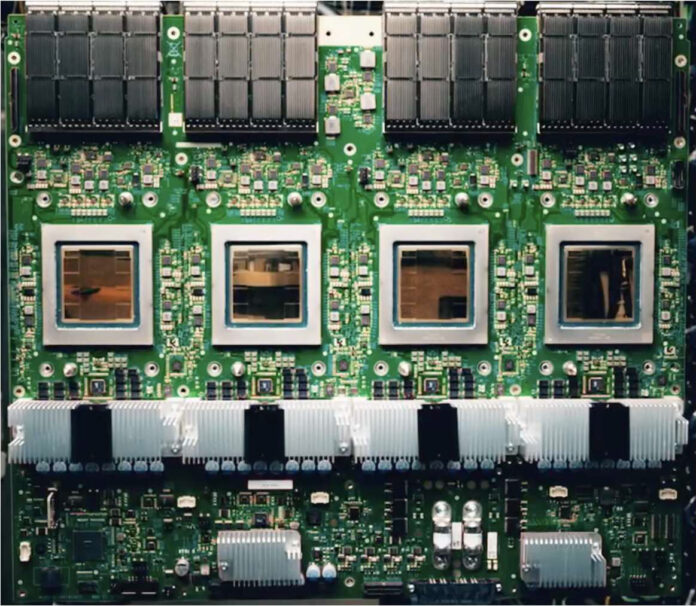

- زیرسیستم محاسباتی با آرایههای تانسوری بسیار بزرگ که میتوانند عملیات ماتریسی عمیق را با بهرهوری بالا انجام دهند.

- زیرسیستم حافظه مجهز به حافظه HBM3e با ظرفیت بسیار بالا (۱۹۲ گیگابایت) و پهنای باند فوقالعاده (بیش از ۷.۳ ترابایت بر ثانیه)، که جریان داده را با سرعتی بسیار بالا تامین میکند.

- زیرسیستم ارتباطی با پهنای باند بینچیپ (ICI) بهمنظور ارتباط سریع میان هزاران چیپ در یک خوشه محاسباتی.

هر چیپ Ironwood میتواند تا حدود 4614 TFLOPs در حالت FP8 (واحد عملیات اعشاری مختص هوش مصنوعی) ارائه دهد و زمانی که در یک Superpod با ۹۲۱۶ چیپ مقیاس شود، این عدد به بیش از ۴۲.۵ ExaFLOPS میرسد ، رقمی که گوگل آن را بیش از ۲۴ برابر قدرت محاسباتی سریعترین ابرکامپیوترهای موجود میداند.

بهبودهای کلیدی Ironwood نسبت به نسلهای پیشین

- افزایش ظرفیت حافظه تا ۶ برابر نسبت به نسل قبل و بهبود پهنای باند تا بیش از ۴.۵ برابر.

- افزایش کارایی انرژی تا ۲ برابر در مقایسه با TPUv6e (Trillium).

- طراحی اختصاصی برای استنتاج در مقیاسهای بسیار بزرگ بهجای تمرکز صرف بر مرحله آموزش.

این ویژگیها Ironwood را به انتخابی ایدهآل برای پردازش مقیاسپذیر AI تبدیل میکند، بهطوری که مدلهای پیشرفتهای مانند Gemini 3 و Claude 4.5 Opus توسط این نسل TPU آموزش یا استنتاج میشوند.

مقایسه Google TPU و Nvidia GPU

معماری و فلسفه طراحی

| ویژگی | Google TPU (Ironwood) | Nvidia GPU (Blackwell/H100) |

| نوع سختافزار | ASIC اختصاصی AI | GPU عمومی با توان محاسباتی بالا |

| طراحی هدف | استنتاج در مقیاس ابری | آموزش و استنتاج متنوع |

| انعطافپذیری | محدود به پردازشهای AI خاص و Google Cloud | پشتیبانی از طیف گستردهای از بارهای کاری |

| اکوسیستم نرمافزاری | XLA و TensorFlow بهینهشده | CUDA، PyTorch و اکوسیستم گسترده |

| مقیاسپذیری | بسیار بالا با شبکهبندی مخصوص TPU Pods | محدودیتهای NVLink در خوشههای بزرگتر |

عملکرد و کارایی

- عملکرد خام: هر چیپ Ironwood حدود ۴.۶ PFLOPs در FP8 ارائه میدهد، رقمی نزدیک به GPUهای سطح بالا مانند Blackwell B200 که حدود ۴.۵ PFLOPs در همین حالت ارائه میدهند.

- پهنای باند حافظه: Ironwood با ۱۹۲ GB HBM3e و پهنای باند بیش از ۷.۳ TB/s در موقعیت بسیار بالاتری نسبت به بسیاری از GPUها قرار دارد.

- کارایی انرژی: TPUها معمولاً نسبت به GPUها توان عملیاتی بر وات بالاتری ارائه میدهند؛ این مزیت در مراکز دادهای با محدودیت مصرف انرژی اهمیت زیادی دارد.

- قابلیت انطباق و پشتیبانی نرمافزاری: GPUها همچنان در تنوع بارهای کاری و اکوسیستم نرمافزار حرف اول را میزنند، بهخصوص در پژوهش و توسعه نرمافزارهای سفارشی و پروژههای غیر استاندارد AI .

مزایا و محدودیتها

مزایای TPU :

- انرژی و هزینه بهینهتر در مقیاسهای بزرگ.

- تمرکز بر بارهای کاری AI با پهنای باند بالا.

- طراحی شده برای استنتاج در مقیاس ابری با عملکرد پایدار.

محدودیتهای TPU :

- محدود به Google Cloud و اکوسیستم خاص آن.

- انعطافپذیری کمتر برای بارهای کاری غیر AI یا سفارشی .

مزایای GPU :

- پشتیبانی قوی از کتابخانهها و چارچوبهای متعدد.

- توانایی اجرای طیف گستردهای از بارهای کاری، از بازی تا شبیهسازیهای علمی.

محدودیتهای GPU :

- استفاده انرژی بالاتر و هزینه بیشتر در مقیاس کلان.

- محدودیت در مقیاسپذیری فوقالعاده بزرگ در خوشههای گسترده.

نتیجهگیری

ظهور TPUهای نسل جدید مانند Ironwood نشان میدهد که مسیر توسعه سختافزار AI به سمت شتابدهندههای تخصصی و بهینهسازیشده برای عملیات تانسوری در مقیاسهای بسیار بزرگ در حال حرکت است. این تراشهها بهخصوص در استنتاج مقیاسپذیر و پردازش مدلهای بزرگ مزایای چشمگیری نسبت به سختافزارهای عمومی دارند.

با این حال، GPUهای Nvidia با اکوسیستم نرمافزاری گسترده و انعطافپذیری بالا همچنان در بسیاری از کاربردهای AI، پردازشهای عمومی و طراحی سفارشی باقی میمانند.

در نهایت، انتخاب بین TPU و GPU به نوع بار کاری، مقیاس پروژه و نیاز به انعطافپذیری نرمافزاری بازمیگردد؛ اما با توجه به روندهای اخیر، ترکیب این دو معماری در پلتفرمهای ابری بهعنوان راهحل بهینه برای آینده AI در حال شکلگیری است.

این موضوع چقدر برای شما مفید بود؟

روی یک ستاره کلیک کنید تا به آن امتیاز دهید!

میانگین امتیاز 5 / 5. امتیاز: 326

تا الان امتیازی ثبت نشده! اولین نفری باشید که به این پست امتیاز می دهید.